Die Nvidia-App verlässt die Betaphase

Ein einziges Programm soll Zugriff auf alle Funktionen und weitere Tools rund um Nvidia-Grafikkarten bieten: übersichtlicher und ohne Zwang zum Log-in.

Ein einziges Programm soll Zugriff auf alle Funktionen und weitere Tools rund um Nvidia-Grafikkarten bieten: übersichtlicher und ohne Zwang zum Log-in.

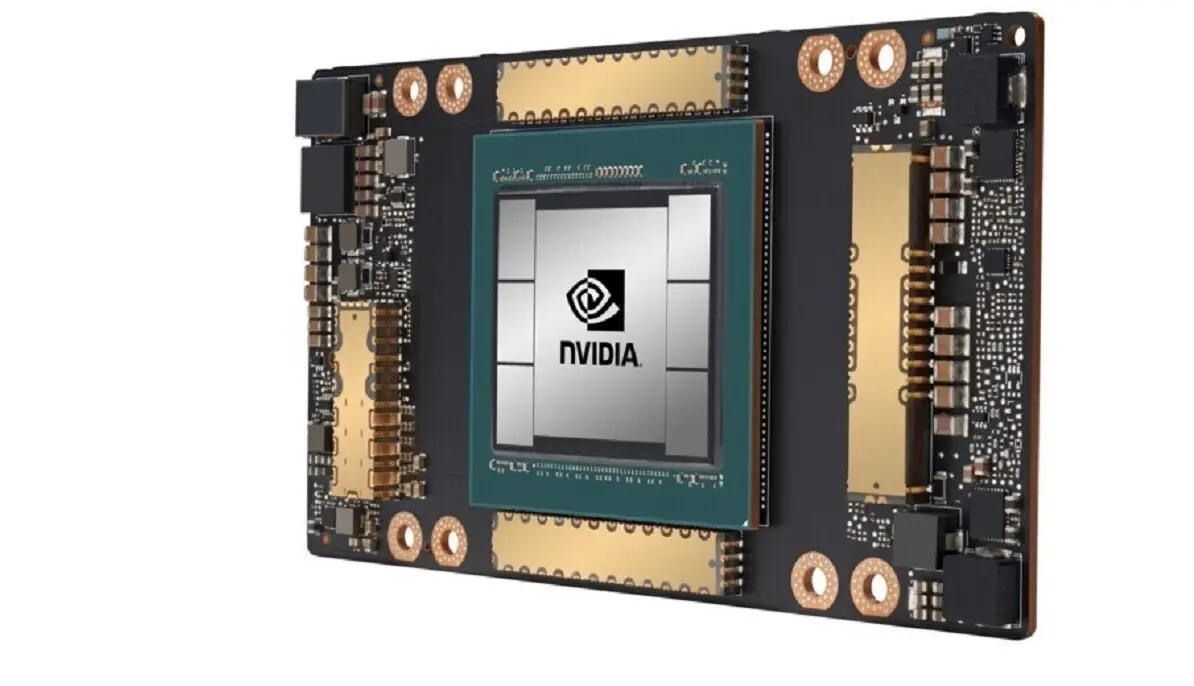

In einem kürzlich veröffentlichten Bericht wurden wichtige Details zu den kommenden NVIDIA Blackwell-Grafikkarten, der RTX 5080 und RTX 5090, enthüllt.

Du hast bereits für diesen

Kommentar abgestimmt...

;-)

© by Ress Design Group, 2001 - 2024